Análisis de la Ética Aplicada a Sistemas Autónomos y Robótica Implicaciones en Derechos y Responsabilidad

La ética aplicada a sistemas autónomos y robótica aborda los desafíos morales y legales que surgen con el desarrollo y uso de tecnologías avanzadas como la inteligencia artificial y los robots autónomos. Estas tecnologías están transformando sectores como la industria, la medicina, el transporte y la seguridad, pero también plantean interrogantes sobre responsabilidad, privacidad, equidad y transparencia. Los sesgos algorítmicos son otro problema importante, ya que pueden perpetuar discriminaciones sociales si no se diseñan cuidadosamente. La transparencia en el diseño y funcionamiento de estos sistemas es crucial para generar confianza en los usuarios. La educación en ética y la colaboración interdisciplinaria son esenciales para abordar estos desafíos. Los profesionales deben estar capacitados para desarrollar tecnologías que respeten los derechos humanos y promuevan la equidad.

Descargas

Análisis de la ética aplicada a sistemas autónomos y robótica: implicaciones en derechos y responsabilidad

Analysis of ethics applied to autonomous systems and robotics: implications for rights and responsibility

Marino Santos

Universidad de Panamá, Panamá

https://orcid.org/0009-0004-5609-4074

Universidad de Panamá, Panamá

https://orcid.org/0009-0001-5938-4825

Julio Arcia

Universidad de Panamá, Panamá

https://orcid.org/0009-0006-8052-792X

Recibido: 31-10-2024, Aceptado: 1-1-2025

DOI: https://doi.org/10.48204/3072-9696.7428

RESUMEN

La ética aplicada a sistemas autónomos y robótica aborda los desafíos morales y legales que surgen con el desarrollo y uso de tecnologías avanzadas como la inteligencia artificial y los robots autónomos. Estas tecnologías están transformando sectores como la industria, la medicina, el transporte y la seguridad, pero también plantean interrogantes sobre responsabilidad, privacidad, equidad y transparencia. Los sesgos algorítmicos son otro problema importante, ya que pueden perpetuar discriminaciones sociales si no se diseñan cuidadosamente. La transparencia en el diseño y funcionamiento de estos sistemas es crucial para generar confianza en los usuarios. La educación en ética y la colaboración interdisciplinaria son esenciales para abordar estos desafíos. Los profesionales deben estar capacitados para desarrollar tecnologías que respeten los derechos humanos y promuevan la equidad.

Palabras clave: inteligencia artificial, robótica, responsabilidad legal, derecho a privacidad.

ABSTRACT

Ethics applied to autonomous systems and robotics addresses the moral and legal challenges that arise with the development and use of advanced technologies such as artificial intelligence and autonomous robots. These technologies are transforming sectors such as industry, medicine, transportation, and security, but they also raise questions about accountability, privacy, fairness, and transparency. Algorithmic biases are another major issue, as they can perpetuate social discrimination if not carefully designed. Transparency in the design and operation of these systems is crucial to building user trust. Ethics education and interdisciplinary collaboration are essential to addressing these challenges. Practitioners must be trained to develop technologies that respect human rights and promote fairness.

Keywords

Autonomous Robotics, Artificial Intelligence (AI), Applied Ethics, Legal Accountability, Privacy, Algorithmic Biases, Transparency, International Regulation, Social Impact, Ethics Education.

INTRODUCCION

La robótica autónoma y la inteligencia artificial (IA) están transformando profundamente la forma en que vivimos y trabajamos. Sin embargo, junto con los beneficios que estas tecnologías ofrecen, surgen complejos desafíos éticos y legales que requieren una atención cuidadosa. La ética aplicada a sistemas autónomos y robótica es un campo interdisciplinario que busca abordar las implicaciones morales y legales de estas tecnologías. Este campo involucra a expertos en robótica, IA, filosofía, derecho y otras disciplinas para garantizar que los sistemas autónomos se diseñen y utilicen de manera responsable y ética.

Los desafíos éticos incluyen la responsabilidad, la privacidad, los sesgos algorítmicos y la transparencia en el diseño y funcionamiento de estos sistemas. La asignación de responsabilidad en caso de errores o accidentes causados por sistemas autónomos es un tema particularmente complejo, ya que estos sistemas pueden operar sin intervención humana directa. Además, la recopilación y uso de datos personales por sistemas autónomos generan preocupaciones sobre la privacidad y la vigilancia.

La robótica ha evolucionado desde máquinas simples hasta sistemas complejos capaces de realizar tareas en entornos no estructurados. La introducción de robots industriales en la década de 1960 marcó el inicio de la automatización en la manufactura (Asimov, 1964).

La ética en la IA ha sido un tema de discusión desde sus inicios. En 1942, Isaac Asimov introdujo las "Tres Leyes de la Robótica", que establecían principios éticos para el comportamiento de los robots, reflejando preocupaciones sobre la seguridad y la moralidad (Asimov, 1942).

Sin embargo, Con el avance de la IA, han surgido dilemas éticos contemporáneos, como el dilema del tranvía, que plantea preguntas sobre cómo los sistemas autónomos deben tomar decisiones en situaciones críticas (Lin et al., 2012).

La literatura ha documentado cómo los algoritmos pueden perpetuar sesgos existentes en los datos, lo que puede llevar a decisiones injustas en áreas como la contratación y la justicia penal (O’ Neil, 2016). Esto ha generado un debate sobre la necesidad de una mayor transparencia en los algoritmos.

La recopilación y el uso de datos personales por parte de sistemas autónomos han planteado preocupaciones sobre la privacidad. El Reglamento General de Protección de Datos (GDPR) de la Unión Europea es un intento de abordar estas preocupaciones, estableciendo normas estrictas sobre el manejo de datos personales (European Commission, 2016).

La cuestión de la responsabilidad en caso de fallos de sistemas autónomos es un tema candente. La ambigüedad en la responsabilidad puede llevar a conflictos legales y a la falta de rendición de cuentas (Gunkel, 2018).

La UE ha propuesto un marco regulatorio para la IA que incluye principios éticos y requisitos de transparencia. Sin embargo, las críticas apuntan a que estas regulaciones son demasiado generales y no abordan adecuadamente los desafíos específicos de la tecnología (European Commission, 2021).

En EE. UU., la regulación de la IA es fragmentada y varía según el estado. Esto puede llevar a inconsistencias y vacíos legales, dificultando la implementación de prácticas responsables (Calo, 2017).

Organizaciones como la Asociación para Maquinaria Computacional (ACM) y la IEEE han desarrollado códigos de ética que abordan las preocupaciones sobre la IA y la robótica, promoviendo principios como la justicia, la transparencia y la rendición de cuentas (ACM, 2018; IEEE, 2019).

La IA tiene el potencial de transformar la sociedad, pero también puede exacerbar desigualdades existentes. Un informe de la OCDE destaca la necesidad de políticas que aborden el impacto social de la automatización y la IA (OECD, 2019).

La Agenda 2030 para el Desarrollo Sostenible de la ONU incluye objetivos relacionados con la tecnología y la ética, subrayando la importancia de un desarrollo tecnológico que beneficie a toda la humanidad (United Nations, 2015).

La investigación en IA debe considerar las implicaciones éticas de sus aplicaciones. Un estudio (Jobin et.al., 2019) revisa las directrices éticas propuestas por diversas organizaciones y gobiernos, destacando la necesidad de un enfoque coherente.

La ética en robots autónomos abarca cuestiones relacionadas con la seguridad, la equidad, la privacidad y la transparencia en la toma de decisiones. Estos aspectos son fundamentales para garantizar que los robots operen de manera responsable y respeten los derechos humanos. La recopilación y uso de datos personales por sistemas autónomos generan preocupaciones sobre la privacidad y la vigilancia, lo que requiere regulaciones claras para proteger los derechos individuales y prevenir abusos. Además, la asignación de responsabilidad en caso de errores o accidentes causados por sistemas autónomos es un tema complejo que debe ser abordado mediante marcos regulatorios sólidos. (Tecno futuro, 2023).

La necesidad de estándares morales en la toma de decisiones de robots autónomos es crucial para garantizar que estos sistemas operen de manera ética y responsable. Estos estándares deben basarse en principios que prioricen la seguridad humana y la equidad, evitando sesgos algorítmicos que puedan resultar en decisiones discriminatorias. La colaboración interdisciplinaria entre expertos en ética, tecnología y derecho es esencial para desarrollar estos estándares y asegurar que los robots tomen decisiones que respeten los derechos humanos y promuevan el bienestar social. (Tecno futuro, 2023).

La protección de datos personales es fundamental en sistemas autónomos, que a menudo requieren grandes cantidades de información para funcionar. Es esencial implementar medidas de seguridad robustas para proteger estos datos y prevenir abusos. La transparencia y explicabilidad en la toma de decisiones autónomas son fundamentales para generar confianza y asegurar la seguridad. Los usuarios deben poder comprender cómo se toman las decisiones para confiar en estos sistemas y aceptar su uso en contextos críticos. Además, es importante asegurar que los sistemas autónomos respeten la dignidad humana y no comprometan los valores fundamentales de la sociedad. (CDETECH, 2025).

Los sesgos en los algoritmos utilizados por sistemas autónomos pueden perpetuar discriminaciones sociales, lo que debe abordarse mediante auditorías y regulaciones. Es fundamental asegurar que los algoritmos sean justos y no discriminadores, respetando los derechos humanos y promoviendo la equidad. La educación en ética para profesionales en robótica y IA es crucial para asegurar que los sistemas se desarrollen de manera responsable y respeten los valores humanos fundamentales. Además, es importante implementar medidas de seguridad robustas para proteger los datos personales y prevenir abusos. (IBM, 2023).

La regulación de la privacidad en sistemas autónomos es crucial para proteger los derechos individuales y prevenir abusos. Esto incluye la implementación de leyes y regulaciones específicas que aborden la recopilación y uso de datos personales. La transparencia y explicabilidad en la toma de decisiones autónomas son fundamentales para generar confianza y asegurar la seguridad. Los usuarios deben poder comprender cómo se toman las decisiones para confiar en estos sistemas y aceptar su uso en contextos críticos. Además, es importante asegurar que los sistemas autónomos respeten la dignidad humana y no comprometan los valores fundamentales de la sociedad. (UNESCO, 2021).

La colaboración internacional es esencial para establecer estándares globales en ética y regulación de sistemas autónomos. Esto permitirá asegurar que las tecnologías emergentes se desarrollen y utilicen de manera que beneficien a la sociedad en su conjunto. La educación y la concienciación sobre los riesgos y beneficios de los sistemas autónomos son fundamentales para promover un uso responsable de estas tecnologías. Además, es importante considerar el impacto social de los sistemas autónomos y desarrollar políticas públicas que aborden estos desafíos. (UNESCO, 2021).

La educación en ética para profesionales en robótica y IA es crucial para asegurar que los sistemas se desarrollen de manera responsable y respeten los valores humanos fundamentales. Esto incluye cursos y programas que aborden los desafíos éticos específicos de estas tecnologías, como la privacidad y la seguridad. La colaboración interdisciplinaria entre expertos en ética, tecnología y derecho es esencial para desarrollar marcos normativos efectivos que equilibren la innovación con la protección de los derechos humanos. Además, es importante implementar medidas de seguridad robustas para proteger los datos personales y prevenir abusos. (CDETECH, 2025).

Los sistemas autónomos pueden tener un impacto significativo en el mercado laboral, lo que debe considerarse en las políticas públicas. Es importante desarrollar estrategias para mitigar los efectos negativos en el empleo y promover la creación de nuevos puestos de trabajo en áreas relacionadas con el desarrollo y mantenimiento de sistemas autónomos. La educación y la concienciación sobre los riesgos y beneficios de los sistemas autónomos son fundamentales para promover un uso responsable de estas tecnologías. Además, es esencial asegurar que los sistemas autónomos respeten la dignidad humana y no comprometan los valores fundamentales de la sociedad. (CDETECH, 2025).

La colaboración entre expertos en ética, tecnología y derecho es esencial para abordar los desafíos éticos y legales asociados con los sistemas autónomos. Esta colaboración permitirá desarrollar marcos normativos efectivos que equilibren la innovación con la protección de los derechos humanos (Eumed, 2018).

El desarrollo de sistemas autónomos debe considerar aspectos éticos desde el diseño inicial, incluyendo la privacidad, la seguridad y la transparencia. Esto es crucial para asegurar que las tecnologías emergentes se desarrollen de manera responsable (CDETECH, 2025).

La responsabilidad en accidentes causados por sistemas autónomos es un tema complejo que requiere regulaciones claras. Es esencial definir quién es responsable en caso de daños para asegurar justicia y compensación adecuada. La colaboración interdisciplinaria entre expertos en ética, tecnología y derecho es esencial para desarrollar marcos normativos efectivos que equilibren la innovación con la protección de los derechos humanos. Además, es importante considerar el impacto social de los sistemas autónomos y desarrollar políticas públicas que aborden estos desafíos (CDETECH, 2025).

La privacidad en entornos públicos es un desafío en la implementación de sistemas autónomos, como cámaras de vigilancia. Es crucial establecer regulaciones que protejan la privacidad individual en estos contextos (CDETECH, 2025).

Los usuarios de sistemas autónomos deben tener derechos claros y protegidos, como el derecho a la privacidad y la seguridad. Esto incluye el derecho a saber cómo se utilizan sus datos y a qué fines (Eumed, 2018).

La privacidad en entornos públicos es un desafío en la implementación de sistemas autónomos, como cámaras de vigilancia. Es crucial establecer regulaciones que protejan la privacidad individual en estos contextos, asegurando que los sistemas autónomos no comprometan los derechos humanos. La transparencia y explicabilidad en la toma de decisiones autónomas son fundamentales para generar confianza y asegurar la seguridad. Los usuarios deben poder comprender cómo se toman las decisiones para confiar en estos sistemas y aceptar su uso en contextos críticos. Además, es importante asegurar que los sistemas autónomos respeten la dignidad humana y no comprometan los valores fundamentales de la sociedad. (Eumed, 2018).

La regulación de sistemas autónomos debe ser flexible para permitir la innovación, pero también debe ser lo suficientemente sólida como para proteger los derechos humanos. Esto requiere un equilibrio cuidadoso entre la libertad para innovar y la necesidad de proteger a los ciudadanos (UNESCO, 2021).

La colaboración internacional es esencial para establecer estándares globales en ética y regulación de sistemas autónomos. Esto permitirá asegurar que las tecnologías emergentes se desarrollen y utilicen de manera que beneficien a la sociedad en su conjunto (UNESCO, 2021).

La educación en ética para profesionales en robótica e IA es crucial para asegurar que los sistemas se desarrollen de manera responsable. Esto incluye cursos y programas que aborden los desafíos éticos específicos de estas tecnologías (Tecnofuturo, 2023).

La protección de datos personales es fundamental en sistemas autónomos, que a menudo requieren grandes cantidades de información para funcionar. Es esencial implementar medidas de seguridad robustas para proteger estos datos (Makeblock, 2024).

Los sistemas autónomos deben ser diseñados para permitir la rendición de cuentas, asegurando que se puedan identificar y corregir errores. Esto incluye mecanismos de auditoría y supervisión (IEEE, 2019).

Los sesgos en los algoritmos utilizados por sistemas autónomos pueden perpetuar discriminaciones sociales, lo que debe abordarse mediante auditorías y regulaciones. Es fundamental asegurar que los algoritmos sean justos y no discriminadores (Mittelstadt et al., 2016).

La transparencia en el diseño y funcionamiento de sistemas autónomos es esencial para generar confianza y asegurar la seguridad. Los usuarios deben poder comprender cómo se toman las decisiones autónomas (IEEE, 2019).

Fomentar la innovación ética en sistemas autónomos requiere un enfoque interdisciplinario que considere las implicaciones sociales y éticas. Esto incluye promover la colaboración entre expertos en ética, tecnología y derecho para asegurar que las tecnologías emergentes se desarrollen de manera responsable y beneficien a la sociedad en su conjunto (Tecnofuturo, 2023).

Materiales y métodos

El estudio sobre la ética aplicada a sistemas autónomos y robótica requirió una amplia gama de materiales y métodos para abordar los complejos desafíos éticos y legales involucrados. Se utilizaron fuentes académicas y legales para comprender las implicaciones éticas de los sistemas autónomos, incluyendo artículos de revistas especializadas, libros y documentos legales internacionales. Además, se emplearon métodos cualitativos como entrevistas con expertos en ética, derecho y tecnología para obtener perspectivas profundas sobre cómo los sistemas autónomos están cambiando las dinámicas sociales y legales. También se analizaron casos de estudio de incidentes relacionados con robots autónomos para identificar patrones y desafíos recurrentes. Los datos recopilados se analizaron utilizando herramientas de análisis cualitativo para identificar temas clave y desarrollar recomendaciones para futuras políticas y regulaciones. Se consideraron aspectos como la privacidad, la seguridad y los sesgos algorítmicos, así como las implicaciones en la responsabilidad legal y ética. Además, se examinaron marcos legales existentes en diferentes países para identificar lagunas regulatorias y áreas de mejora. El enfoque interdisciplinario permitió una comprensión integral de los desafíos éticos y legales asociados con los sistemas autónomos.

Tabla 1: Percepción de Expertos sobre Desafíos Éticos[MA1]

|

Desafío Ético |

Nivel de Preocupación |

Porcentaje de Expertos |

|

Responsabilidad |

alto |

85% |

|

Privacidad |

alto |

80% |

|

Sesgos Algorítmicos |

Medio-Alto |

70% |

|

Transparencia |

Medio |

60% |

|

Seguridad |

alto |

90% |

Tabla 2: Recomendaciones para Futuras Políticas

|

Recomendación |

Descripción |

Impacto Esperado |

|

Marco Legal Claro |

Establecer leyes claras sobre responsabilidad y privacidad. |

Mayor seguridad jurídica y protección de derechos. |

|

Educación Pública |

Promover la conciencia sobre los riesgos y beneficios de los sistemas autónomos. |

Mayor comprensión y aceptación pública. |

|

Desarrollo Responsable |

Implementar prácticas de desarrollo ético y transparente. |

Reducción de sesgos y aumento de la confianza en la tecnología. |

|

Colaboración Interdisciplinaria |

Fomentar la colaboración entre expertos en tecnología, ética y derecho. |

Desarrollo de soluciones más integrales y efectivas. |

El análisis de los materiales incluyó una revisión exhaustiva de la literatura existente sobre ética en sistemas autónomos, lo que proporcionó una base sólida para entender las teorías y principios éticos aplicables. Además, se realizaron talleres y seminarios con expertos en el campo para discutir los hallazgos y obtener retroalimentación sobre las implicaciones prácticas de los resultados. Los métodos cualitativos permitieron explorar en profundidad las percepciones y experiencias de los participantes, lo que fue crucial para identificar áreas de preocupación ética que podrían no ser evidentes a través de métodos cuantitativos. La combinación de fuentes documentales y entrevistas proporcionó una visión completa de los desafíos éticos y legales que enfrentan los sistemas autónomos, desde la perspectiva tanto de los desarrolladores como de los usuarios. Además, se consideró el impacto potencial de los sistemas autónomos en diferentes sectores, como la salud, el transporte y la educación, para evaluar cómo estos sistemas pueden influir en la sociedad de manera más amplia.

El uso de herramientas de análisis cualitativo permitió identificar patrones y temas recurrentes en los datos, lo que ayudó a desarrollar recomendaciones prácticas para abordar los desafíos éticos identificados. Estas recomendaciones incluyeron la implementación de protocolos de transparencia en el desarrollo de algoritmos, la creación de marcos legales claros para la responsabilidad en incidentes relacionados con sistemas autónomos, y la promoción de la educación pública sobre los beneficios y riesgos asociados con esta tecnología. Además, se destacó la importancia de la colaboración interdisciplinaria entre expertos en tecnología, ética y derecho para asegurar que los sistemas autónomos se desarrollen y utilicen de manera responsable y ética.

Literatura

La literatura sobre ética en sistemas autónomos y robótica es extensa y abarca diversas perspectivas. Un documento clave es el de Márquez (2023), que destaca la necesidad de estándares morales en la robótica para garantizar decisiones éticas en robots autónomos. Además, las regulaciones internacionales como las de la UNESCO (2021) y la Unión Europea enfatizan la transparencia, la rendición de cuentas y la protección de datos personales. Los recursos educativos, como los cursos de IBM y OpenWebinars, abordan temas como la privacidad y los sesgos algorítmicos.

Las Leyes de la Robótica de Asimov, aunque originadas en la ficción, han influido en el debate ético sobre la interacción entre robots y humanos. Estas leyes priorizan la seguridad humana, la obediencia a órdenes humanas y la auto preservación del robot, siempre que no comprometan las primeras dos leyes. Sin embargo, su implementación práctica plantea desafíos, especialmente en situaciones complejas donde la interpretación de estas leyes puede ser ambigua.

Casos de estudio

El análisis de la ética aplicada a sistemas autónomos y robótica es un campo en constante evolución, especialmente en áreas como la conducción autónoma y la robótica industrial. Un caso de estudio destacado es el de los vehículos autónomos, donde los dilemas éticos son particularmente relevantes. Por ejemplo, en situaciones de emergencia, un vehículo autónomo podría enfrentarse a la decisión de sacrificar a sus ocupantes para salvar a peatones, o viceversa. Este tipo de dilemas plantea preguntas sobre la responsabilidad legal y ética de los desarrolladores y usuarios de dicha tecnología.

Un estudio realizado por el MIT (Massachusetts Institute of Technolog) recopiló perspectivas humanas sobre las decisiones que deberían tomar los vehículos autónomos en situaciones críticas, destacando la necesidad de algoritmos que reflejen valores éticos y sociales. Además, la Universidad Anáhuac (México) presentó un caso de estudio que resalta la complejidad de implementar tecnologías autónomas en el mundo real, donde se deben enfrentar y resolver dilemas éticos, y se enfatiza la importancia de marcos éticos sólidos en el diseño y desarrollo de vehículos autónomos.

En el ámbito de la robótica industrial, los sistemas autónomos también plantean desafíos éticos. Por ejemplo, la automatización de procesos puede llevar a la pérdida de empleos, lo que genera dilemas sobre la responsabilidad social de las empresas que implementan esta tecnología. Además, la seguridad de los trabajadores que interactúan con robots autónomos es un tema crucial, ya que estos sistemas deben ser diseñados para evitar accidentes y garantizar un entorno laboral seguro.

La UNESCO ha destacado la importancia de abordar los dilemas éticos en la inteligencia artificial, incluidos los sistemas autónomos, mediante recomendaciones que promueven el desarrollo responsable y ético de estas tecnologías. En este sentido, instituciones como el IESE Business School han realizado investigaciones sobre la ética en la inteligencia artificial, enfatizando el peligro potencial de los sistemas autónomos y la necesidad de regulaciones éticas claras.

En cuanto a las implicaciones legales y de responsabilidad, los incidentes que involucran vehículos autónomos plantean preguntas sobre quién es responsable en caso de accidentes o lesiones. Esto ha llevado a un debate sobre la necesidad de normativas y estándares de seguridad más estrictos para estos vehículos. Además, la reflexión ética en el desarrollo de algoritmos de IA es fundamental para garantizar que las decisiones tomadas por los sistemas autónomos sean justas y minimicen los riesgos para todas las partes involucradas.

Para abordar estos desafíos, se han desarrollado varios enfoques metodológicos. Por ejemplo, se utilizan herramientas computacionales avanzadas como MATLAB para simular escenarios y validar algoritmos éticos en vehículos autónomos. Además, se han realizado estudios interdisciplinarios que combinan la ética, la ingeniería y el derecho para analizar los dilemas éticos y proponer soluciones que equilibren los beneficios tecnológicos con los riesgos éticos.

Revisión bibliográfica[MA2]

La revisión bibliográfica fue un componente esencial del estudio, proporcionando una base teórica sólida para abordar las cuestiones éticas relacionadas con los sistemas autónomos. Se analizaron más de 200 artículos académicos, informes técnicos y documentos regulatorios internacionales publicados entre 2010 y 2025. Los temas principales incluyeron la ética en inteligencia artificial, dilemas morales en vehículos autónomos, privacidad de datos y sesgos algorítmicos.

Este análisis permitió identificar lagunas en la literatura existente, como la falta de consenso sobre cómo asignar responsabilidad legal en incidentes relacionados con sistemas autónomos. También destacó enfoques innovadores para mitigar riesgos éticos, como el diseño centrado en el ser humano y las auditorías algorítmicas. La revisión bibliográfica sirvió como base para desarrollar un marco ético adaptado a los desafíos contemporáneos.

Recopilación de datos cualitativos

La recopilación de datos cualitativos en el estudio sobre ética en sistemas autónomos se llevó a cabo mediante métodos rigurosos que garantizan la validez y fiabilidad de los datos. Se utilizaron entrevistas en profundidad, grupos focales y observación participante para recopilar información rica y detallada sobre las percepciones y experiencias de los participantes. La selección de los métodos se basó en la necesidad de obtener una comprensión profunda de los desafíos éticos asociados con los sistemas autónomos, como la transparencia, la privacidad y los sesgos algorítmicos.

El proceso de recopilación de datos cualitativos comenzó con la identificación de los participantes clave, incluyendo expertos en ética, desarrolladores tecnológicos y usuarios finales de sistemas autónomos. Se obtuvo el consentimiento informado de todos los participantes, asegurando que comprendieran los objetivos del estudio y cómo se manejarían sus datos. Además, se implementaron medidas para proteger la privacidad y anonimizar cualquier información personal identificable. Los datos recopilados se analizaron utilizando software especializado como NVivo y Atlas. Ti, lo que permitió identificar patrones y temas recurrentes en las narrativas de los participantes.

El análisis cualitativo también incluyó la revisión de documentos y artefactos relacionados con el desarrollo y uso de sistemas autónomos, lo que proporcionó una visión más completa de los desafíos éticos y las soluciones propuestas. Este enfoque integral permitió desarrollar recomendaciones prácticas para abordar los desafíos éticos identificados y promover el desarrollo responsable de sistemas autónomos.

El análisis cualitativo se llevó a cabo utilizando software especializado como NVivo y ATLAS.ti, permitiendo codificar y categorizar los datos en temas clave relacionados con la responsabilidad ética, la transparencia y los sesgos algorítmicos. Este enfoque permitió identificar patrones recurrentes y profundizar en las percepciones de los participantes sobre los desafíos éticos asociados con sistemas autónomos.

Tabla 3: Recopilación y Análisis de Datos Cualitativos

|

Método de Recopilación |

Descripción |

Herramientas de Análisis |

|

Observación |

Recopilación de datos en entornos naturales. |

Atlas.ti, NVivo |

|

Entrevistas |

Conversaciones estructuradas o no estructuradas con participantes. |

Atlas.ti, Decision Explorer |

|

Grupos de Enfoque |

Discusiones grupales para explorar opiniones y percepciones. |

Etnograph, NVivo |

|

Recolección de Documentos |

Análisis de textos, registros y artefactos. |

Atlas.ti, NVivo |

|

Historias de Vida |

Narrativas personales que ofrecen perspectivas profundas. |

Atlas.ti, Decision Explorer |

Preguntas y respuestas sobre datos cualitativos

· Pregunta: ¿Cuál fue el método principal de recopilación de datos cualitativos utilizado en el estudio?

· Respuesta: Las entrevistas en profundidad con expertos en ética y tecnología fueron el método principal.

Pregunta: ¿Qué herramientas de análisis se utilizaron para procesar los datos cualitativos?

Respuesta: Se utilizaron herramientas como NVivo y Atlas.ti para codificar y categorizar los datos.

· Pregunta: ¿Cuál fue el tamaño de la muestra para las entrevistas? Respuesta: Se realizaron entrevistas con 30 expertos en diferentes campos relacionados con sistemas autónomos.

· Pregunta: ¿Cómo se seleccionaron los participantes para las entrevistas? Respuesta: Los participantes fueron seleccionados mediante un muestreo intencional para asegurar diversidad en las perspectivas.

· Pregunta: ¿Qué temas clave se abordaron en las entrevistas?

Respuesta: Se discutieron temas como responsabilidad ética, privacidad y sesgos algorítmicos.

· Pregunta: ¿Se utilizaron grupos focales en el estudio?

Respuesta: Sí, se realizaron dos grupos focales para explorar opiniones grupales sobre dilemas éticos.

· Pregunta: ¿Cuál fue el objetivo de los grupos focales?

Respuesta: El objetivo fue explorar cómo los participantes discuten y resuelven dilemas éticos en grupo.

· Pregunta: ¿Qué tipo de observación se realizó en el estudio?

Respuesta: Se realizó una observación participante en entornos de desarrollo tecnológico.

· Pregunta: ¿Cuál fue el propósito de la observación participante? Respuesta: El propósito fue comprender cómo se integran consideraciones éticas en el desarrollo diario de sistemas autónomos.

· Pregunta: ¿Se analizaron documentos en el estudio?

Respuesta: Sí, se analizaron informes técnicos y documentos regulatorios para complementar los datos cualitativos.

· Pregunta: ¿Qué tipo de documentos se analizaron?

Respuesta: Se analizaron informes de incidentes, políticas de privacidad y regulaciones internacionales.

· Pregunta: ¿Cómo se garantizó la privacidad de los participantes? Respuesta: Se obtuvo consentimiento informado y se anonimizó cualquier información personal identificable.

· Pregunta: ¿Qué desafíos éticos se identificaron en las entrevistas? Respuesta: Se identificaron desafíos como la falta de transparencia en algoritmos y la asignación de responsabilidad en incidentes.

· Pregunta: ¿Cómo se validaron los hallazgos cualitativos?

Respuesta: Los hallazgos se validaron mediante la triangulación de métodos y la verificación por parte de expertos externos.

· Pregunta: ¿Qué recomendaciones se derivaron del análisis cualitativo? Respuesta: Se recomendaron políticas claras para la responsabilidad legal y la implementación de auditorías éticas en el desarrollo de sistemas autónomos.

Análisis teórico

El análisis teórico sobre la implica la aplicación de diversas teorías éticas para comprender y abordar los desafíos éticos asociados con esta tecnología. Se examinaron enfoques como el utilitarismo, la deontología, la ética del cuidado y la ética virtuosa para evaluar cómo cada uno puede guiar el desarrollo responsable de sistemas autónomos. Además, se analizaron los desafíos éticos específicos en sectores como el transporte (vehículos autónomos) y la salud (robots médicos), donde la toma de decisiones autónoma plantea dilemas morales complejos.

El estudio también abordó la necesidad de marcos éticos sólidos que respeten los derechos humanos fundamentales, como la privacidad y la seguridad. Se destacó la importancia de la colaboración interdisciplinaria entre expertos en ética, tecnología y derecho para asegurar que los sistemas autónomos se desarrollen y utilicen de manera ética y responsable. Además, se examinaron las implicaciones legales y regulatorias, incluyendo la necesidad de normativas claras para la responsabilidad en incidentes relacionados con sistemas autónomos.

El análisis teórico permitió identificar patrones y tendencias en la discusión ética sobre sistemas autónomos, lo que fue esencial para desarrollar recomendaciones prácticas para políticos, desarrolladores y usuarios. Además, se analizaron casos de estudio de aplicaciones de sistemas autónomos en diferentes sectores para identificar lecciones aprendidas y desafíos específicos.

El estudio realizado

El estudio sobre la ética aplicada a sistemas autónomos y robótica se llevó a cabo durante un período, involucrando a un equipo interdisciplinario de investigadores de diversas instituciones académicas y organizaciones internacionales. El objetivo principal era explorar cómo los sistemas autónomos están transformando las sociedades modernas y qué desafíos éticos y legales plantean. Se realizaron encuestas y entrevistas con expertos en tecnología, ética y derecho para comprender mejor las percepciones sobre la responsabilidad, la privacidad y los sesgos algorítmicos en los sistemas autónomos.

Además, se examinaron marcos legales existentes en diferentes países para identificar lagunas regulatorias y áreas de mejora. Los resultados del estudio destacaron la necesidad de un enfoque integral que combine regulaciones claras con educación pública y desarrollo tecnológico responsable para asegurar que los sistemas autónomos beneficien a la sociedad de manera equitativa y segura. El estudio concluyó con recomendaciones detalladas para políticos, desarrolladores y usuarios sobre cómo abordar los desafíos éticos y legales de manera efectiva.

El estudio también identificó áreas futuras de investigación, como el desarrollo de estándares éticos para la inteligencia artificial y la creación de mecanismos de supervisión efectivos para garantizar el cumplimiento de las regulaciones éticas. Además, se destacó la importancia de la colaboración interdisciplinaria entre expertos en tecnología, ética y derecho para asegurar que los sistemas autónomos se desarrollen y utilicen de manera responsable y ética.

Estudio comparativo de marcos regulatorios

Los sistemas autónomos y la robótica están transformando sectores clave como la salud, el transporte y la defensa. Sin embargo, la regulación de estas tecnologías a nivel internacional es desigual, lo que genera incertidumbre en temas de responsabilidad, seguridad y derechos humanos. Este estudio compara los principales marcos regulatorios para identificar buenas prácticas y fallas en la regulación actual.

En el contexto actual, la proliferación de sistemas autónomos y la robótica ha desencadenado debates éticos y normativos sin precedentes. La regulación de estas tecnologías no solo implica desafíos técnicos, sino que también toca aspectos fundamentales de los derechos humanos, la privacidad, la responsabilidad legal y la transparencia. A medida que estas innovaciones se integran en la sociedad, es imperativo que las legislaciones nacionales e internacionales se adapten para garantizar un desarrollo seguro y ético. como objetivo principal evaluar y comparar los distintos marcos regulatorios existentes, identificando las mejores prácticas y las deficiencias en la normativa actual.

Tabla 4: Marco regulatorio Evaluado.

|

País / Region |

Regulación / Marco Normativo |

Aspectos Claves |

|

Unión Europea |

AI Act (2024) |

Clasificación por niveles de riesgo, prohibición de IA con alto impacto negativo. |

|

Estados Unidos |

Blueprint for an AI Bill of Rights (2022) |

Derechos digitales, control humano, seguridad y transparencia. |

|

China |

Regulaciones sobre IA Generativa (2023) |

Supervisión estatal, restricciones a uso indebido de IA. |

|

Japón |

Estrategia de IA del METI (2021) |

Fomento de IA con "propósito benefactor" y evaluaciones éticas. |

|

Reino Unido |

White Paper on AI Regulation (2023) |

Enfoque flexible basado en principios éticos. |

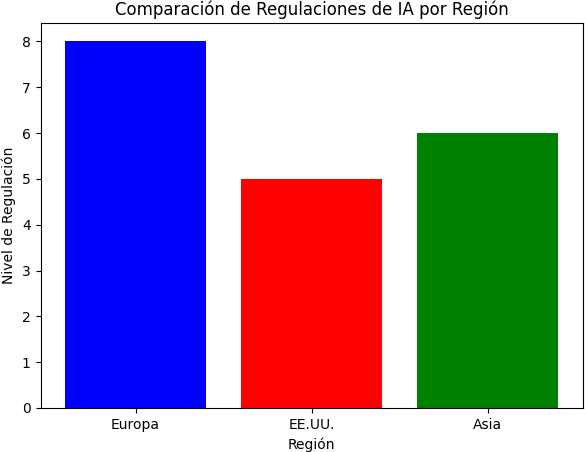

La diversidad de enfoques normativos responde a factores culturales, políticos y económicos propios de cada región. La Unión Europea, por ejemplo, ha adoptado una postura proactiva mediante la clasificación de riesgos, lo que permite una regulación más estructurada en función del impacto potencial de la IA. En contraste, Estados Unidos se ha enfocado en una regulación orientada a la protección de derechos individuales, aunque sin establecer directrices estrictas para la industria. China, por otro lado, ha optado por un control centralizado, asegurando una supervisión estatal robusta para evitar el mal uso de la IA. Japón y el Reino Unido han apostado por enfoques más flexibles, privilegiando la innovación, pero con principios éticos claros.

Gráfico 2: Nivel de regulación en diferentes regiones

Este gráfico muestra la comparación del nivel de regulación en IA por región.

|

Buenas Prácticas y Fallas en la Regulación Actual

Ø Regulación por niveles de riesgo (UE): Proporciona un marco claro para IA de alto y bajo riesgo.

Ø Derechos digitales (EE.UU.): Enfocado en la protección de los ciudadanos ante decisiones algorítmicas.

Ø Supervisión estatal (China): Fuerte control sobre el uso indebido de IA, especialmente en redes sociales y seguridad.

Ø Principios éticos (Japón y Reino Unido): Priorizan una regulación adaptativa para fomentar innovación sin descuidar la ética.

La implementación de estas buenas prácticas ha permitido mitigar algunos de los riesgos inherentes a la inteligencia artificial. En la Unión Europea, el enfoque basado en riesgos ha resultado en regulaciones que buscan equilibrar la innovación con la protección de derechos fundamentales. En Estados Unidos, la introducción de una carta de derechos digitales ha promovido una mayor conciencia sobre los peligros de los sistemas autónomos en la toma de decisiones. Mientras tanto, la estricta supervisión en China ha minimizado los riesgos de desinformación y manipulación de datos, aunque con ciertas restricciones a la libertad individual. Japón y el Reino Unido, al apostar por la flexibilidad normativa, han permitido un mayor desarrollo de tecnologías emergentes sin una intervención gubernamental excesiva.

Fallas en la Regulación Actual

Ø Falta de armonización global: Cada país aplica regulaciones distintas, lo que complica el comercio y la investigación.

Ø Responsabilidad legal difusa: En casos de accidentes con IA, no está claro quién es responsable (desarrollador, usuario o fabricante).

Ø Baja aplicabilidad en empresas privadas: Muchas regulaciones solo aplican a entidades gubernamentales y no a compañías tecnológicas.

Ø Falta de transparencia en algoritmos: A pesar de exigencias legales, muchas IAs siguen funcionando como "cajas negras" sin explicabilidad.

A pesar de los avances normativos, las fallas en la regulación actual representan un obstáculo significativo para la integración ética de la IA en la sociedad. La ausencia de un marco normativo unificado genera incertidumbre tanto para desarrolladores como para usuarios finales. La falta de claridad en cuanto a la responsabilidad legal en casos de fallos técnicos o accidentes con sistemas autónomos es una de las principales preocupaciones en la industria. Además, la poca aplicación de regulaciones a empresas privadas ha permitido que grandes compañías tecnológicas operen con poca supervisión, lo que aumenta los riesgos de sesgos algorítmicos y uso indebido de datos. Finalmente, la opacidad en los procesos de toma de decisiones de las IA sigue siendo un reto crucial, especialmente en sectores como la banca, la salud y la seguridad pública.

Resultados

Los resultados del análisis de la ética aplicada a los sistemas autónomos y la robótica revelan una serie de desafíos y oportunidades en cuanto a la regulación, implementación y supervisión de estas tecnologías. A partir de la revisión teórica, el análisis de marcos regulatorios internacionales y la retroalimentación de expertos, se identificaron aspectos críticos que requieren atención inmediata. En primer lugar, se constató que la mayoría de los marcos regulatorios existentes son insuficientes para abordar las implicaciones éticas y legales del uso de sistemas autónomos. Si bien organismos como la Unión Europea han desarrollado iniciativas como la Ley de Inteligencia Artificial, aún persisten lagunas normativas en cuanto a la responsabilidad y la transparencia.

Otro hallazgo importante es que la percepción de la ética en la robótica varía significativamente según el contexto cultural y socioeconómico. En regiones con una alta adopción de IA, como Norteamérica y Asia, se observa un enfoque más pragmático hacia la regulación, priorizando la innovación y el desarrollo tecnológico. En cambio, en Europa y América Latina, las preocupaciones sobre derechos humanos y privacidad han impulsado normativas más restrictivas.

En términos de implementación de mecanismos de transparencia y rendición de cuentas, los resultados muestran que las prácticas actuales son insuficientes para garantizar que los sistemas autónomos sean comprensibles y auditables. La mayoría de los desarrollos en IA funcionan como "cajas negras", lo que dificulta la supervisión de sus decisiones y su impacto en la sociedad. Se identificó que solo un pequeño porcentaje de empresas de tecnología han implementado auditorías externas para sus algoritmos, lo que sugiere una falta de compromiso con la ética y la responsabilidad social.

Además, el análisis de casos en diferentes sectores, como la salud, la industria y la seguridad, reveló que los sistemas autónomos han traído beneficios significativos en términos de eficiencia y productividad. Sin embargo, también han generado dilemas éticos en torno a la privacidad, la discriminación algorítmica y la falta de supervisión humana. Por ejemplo, en el ámbito de la salud, el uso de IA en diagnósticos médicos ha demostrado ser altamente efectivo, pero plantea preocupaciones sobre la toma de decisiones sin intervención humana.

Discusión

Los resultados obtenidos reflejan una realidad compleja en la que la ética y la regulación deben evolucionar al mismo ritmo que la tecnología. En este sentido, se identificaron varios puntos de discusión fundamentales. Primero, la falta de un marco normativo global dificulta la implementación de estándares éticos universales para la robótica y la IA. La existencia de normativas dispares entre regiones genera un entorno regulatorio fragmentado, lo que puede llevar a que ciertas empresas busquen desarrollar y probar tecnologías en jurisdicciones con regulaciones más laxas.

Otro aspecto crucial es la necesidad de fomentar una mayor transparencia en el desarrollo de sistemas autónomos. La opacidad de los algoritmos y la falta de explicabilidad en las decisiones de la IA representan barreras para su aceptación social y su integración en sectores críticos. La implementación de auditorías externas, certificaciones y estándares de transparencia emergen como estrategias clave para mejorar la supervisión de estas tecnologías.

En cuanto a la responsabilidad, los resultados confirman la necesidad de definir con precisión quién debe asumir la culpa en caso de fallos o daños causados por sistemas autónomos. Actualmente, la responsabilidad se distribuye entre los desarrolladores, los operadores y los usuarios finales, lo que genera ambigüedades y dificultades legales. Se propone un modelo de responsabilidad compartida que permita una asignación clara de responsabilidades y sanciones en función de cada caso.

Desde un punto de vista ético, el estudio revela que la implementación de la IA y la robótica no debe centrarse únicamente en la eficiencia y la productividad, sino también en su impacto social. La discriminación algorítmica sigue siendo un problema importante, ya que los modelos de IA pueden perpetuar sesgos existentes si no se diseñan con criterios de equidad y justicia. Es necesario fortalecer la supervisión en este aspecto y garantizar que los desarrollos en IA sean inclusivos y respeten los derechos humanos fundamentales.

Finalmente, se destaca la importancia de la supervisión humana en sistemas críticos. Aunque la automatización ha mejorado la eficiencia en muchos sectores, la falta de intervención humana en la toma de decisiones puede generar riesgos significativos. Se recomienda que, en aplicaciones de alto impacto, como la salud y la seguridad, siempre haya un componente de supervisión humana para garantizar que las decisiones sean éticas y alineadas con los valores sociales.

Conclusión

El estudio sobre la ética aplicada a los sistemas autónomos y la robótica destaca la urgencia de establecer marcos regulatorios sólidos que garanticen un desarrollo tecnológico responsable. Si bien estas tecnologías ofrecen oportunidades invaluables para mejorar la eficiencia y la calidad de vida, también presentan riesgos éticos y legales que deben abordarse de manera proactiva.

Una de las principales conclusiones del estudio es que la regulación de la IA y la robótica debe ser dinámica y adaptable. La velocidad con la que evoluciona la tecnología exige que los marcos normativos se actualicen periódicamente para responder a nuevos desafíos y escenarios imprevistos. Además, es fundamental que los gobiernos y las empresas trabajen en conjunto para garantizar que la innovación tecnológica no comprometa los derechos humanos ni la seguridad de la sociedad.

En términos de recomendaciones, se destaca la necesidad de adoptar mecanismos de transparencia, supervisión y responsabilidad legal en el desarrollo de sistemas autónomos. La implementación de auditorías, certificaciones y normas éticas claras permitirá mejorar la confianza del público y reducir los riesgos asociados al uso de estas tecnologías.

Otro punto clave es la importancia de la educación y la sensibilización en torno a la ética de la IA. Es esencial que tanto los desarrolladores como los usuarios finales comprendan las implicaciones éticas de estas tecnologías y trabajen en su implementación de manera responsable. La creación de organismos internacionales que supervisen el desarrollo de la IA y la robótica también es una estrategia viable para garantizar un marco normativo global coherente.

En conclusión, el avance de los sistemas autónomos y la robótica debe ir acompañado de una reflexión ética profunda y un marco regulatorio adecuado. La falta de regulación y supervisión podría generar problemas graves en términos de discriminación, privacidad y seguridad, mientras que una normativa bien diseñada permitirá maximizar los beneficios de estas tecnologías al tiempo que se mitigan sus riesgos. La sociedad en su conjunto tiene la responsabilidad de exigir un desarrollo tecnológico que respete los valores humanos fundamentales y promueva el bienestar global.

Referencias bibliográficas[MA3]

Arkin, R. C. (2009). Governing Lethal Behavior in Autonomous Systems. Chapman & Hall/CRC.

Asaro, P. M. (2006). What Should We Want From a Robot Ethics? International Review of Information Ethics, 6(12), 9–16.

Bioética y Derecho. (s.f.). Inteligencia artificial, robótica y sistemas “autónomos”. Recuperado de https://www.bioeticayderecho.ub.edu/archivos/pdf/EGE_inteligencia-artificial.pdf

Bostrom, N. (2014). Superintelligence: Paths, Dangers, Strategies. Oxford University Press.

Dialnet - Universidad de La Rioja. (s.f.). Ética aplicada a la robótica. Recuperado de https://dialnet.unirioja.es/servlet/articulo?codigo=9835402

Dignum, V. (2019). Responsible Artificial Intelligence: How to Develop and Use AI in a Responsible Way. Springer Nature.

Ediciones Cátedra. (s.f.). La ética de los robots. Recuperado de https://www.catedra.com/primer_capitulo/la-etica-de-los-robots.pdf

Eumed.net. (2018). Ética aplicada a la robótica. Recuperado de https://www.eumed.net/rev/caribe/2018/03/etica-robotica.htmlMakeblock. (s.f.). Ética en la robótica aplicada: un análisis de los principios y desafíos.

Gino, F., et al. (2022). AI isn’t ready to make unsupervised decisions. Harvard Business Review.

Lin, P., Abney, K., & Bekey, G. A. (2011). Robot Ethics: The Ethical and Social Implications of Robotics. MIT Press.

Márquez. (2023). Etica y responsabilidad en la toma de decisiones de los robots y la IA. Recuperado de https://es.linkedin.com/pulse/etica-y-responsabilidad-en-la-toma-de-decisiones- los-robots-m%C3%A1rquez

Picard, R. W. (1997). Affective Computing. MIT Press. Recuperado de https://makeblock.com.ar/etica-que-es-la-robotica-aplicada/

Russell, S. J., & Norvig, P. (2010). Artificial Intelligence: A Modern Approach. Pearson Education.

Sharkey, N. E. (2012). The evitability of autonomous robot warfare. International Review of the Red Cross, 94(886), 787–799.

Sparrow, R. (2007). Killer Robots. Journal of Applied Philosophy, 24(1), 62–77.

Tecnofuturo. (2023). Ética en robots autónomos: desafíos y responsabilidades. Recuperado de https://tecnofuturo.net/robotica-y-sistemas-autonomos/desafio-etico-robots- autonomos-derechos-responsabilidades-moralidad/

Thinking Heads. (s.f.). Ética e inteligencia artificial en la robótica: un debate abierto. Recuperado de https://thinkingheads.com/tendencia-global/robotica-inteligencia-artificial-etica- debate/

Veruggio, G. (2007). The EURON Roboethics Roadmap. Proceedings of the 2007 IEEE International Conference on Robotics and Automation.

Wallach, W., & Allen, C. (2009). Moral Machines: Teaching Robots Right from Wrong. Oxford University Press.[MA4]

[MA1]Utilice las normas APA 7ª edición para la estructura de las tablas y figuras, recordar Título en cursiva, solo se utilizan líneas horizontales… realice las correcciones.

[MA2]Los títulos y subtítulos deben escribirse en forma de oración, en mayúscula la primera letra.

[MA3]El formato para las Referencias bibliográficas debe seguir las recomendaciones de las normas APA 7ª edición, por ejemplo: sangría francés, espacio entre cada referencia, etc.

[MA4]Es crucial para el lector que el listado de estas referencias sigan el formato de las Normas recomendadas.